Automatisierung ist der Schlüssel zur Effizienzsteigerung in der modernen Arbeitswelt. Besonders bei der Verwaltung großer Datenmengen oder sich wiederholender Aufgaben kann die Automatisierung erhebliche Vorteile bieten. LibreOffice, eine der führenden freien Office-Suiten, bietet vielfältige Möglichkeiten, um Arbeitsabläufe durch Automatisierung zu optimieren, insbesondere auf dedizierten Servern. Dieser Beitrag beleuchtet, wie erweiterte Automatisierungstechniken in LibreOffice eingesetzt werden können, um die Effizienz zu maximieren.

Herausforderungen in der Büroautomatisierung

In vielen Unternehmen sind Office-Programme unverzichtbare Werkzeuge. Dennoch gibt es Herausforderungen, die die Effizienz beeinträchtigen können. Manuelle Datenverarbeitung ist zeitaufwändig und fehleranfällig. Wiederholte Eingaben und Formatierungen beanspruchen wertvolle Ressourcen und können die Produktivität erheblich senken. Diese Probleme werden noch komplexer, wenn große Datenmengen auf dedizierten Servern verarbeitet werden müssen, wo Geschwindigkeit und Zuverlässigkeit entscheidend sind.

Die Rolle dedizierter Server

Dedizierte Server bieten eine leistungsstarke Plattform zur Verarbeitung komplexer Aufgaben. Sie ermöglichen es, große Datenmengen effizient zu verwalten und zu verarbeiten. Doch ohne geeignete Automatisierungstechniken kann das volle Potenzial dieser Server nicht ausgeschöpft werden. Hier setzt die Automatisierung mit LibreOffice an, um diese Herausforderungen zu meistern und die Effizienz zu steigern.

Automatisierungstechniken in LibreOffice

LibreOffice bietet verschiedene Möglichkeiten zur Automatisierung, die von einfachen Makros bis hin zu komplexen Skripten reichen. Diese Techniken helfen, Routineaufgaben zu automatisieren und die Konsistenz der Datenverarbeitung zu gewährleisten.

Makros und Skripte

Makros sind eine der einfachsten Methoden zur Automatisierung in LibreOffice. Sie ermöglichen es, wiederkehrende Aufgaben mit einem einzigen Klick auszuführen. Ein einfaches Makro zur Automatisierung könnte beispielsweise so aussehen:

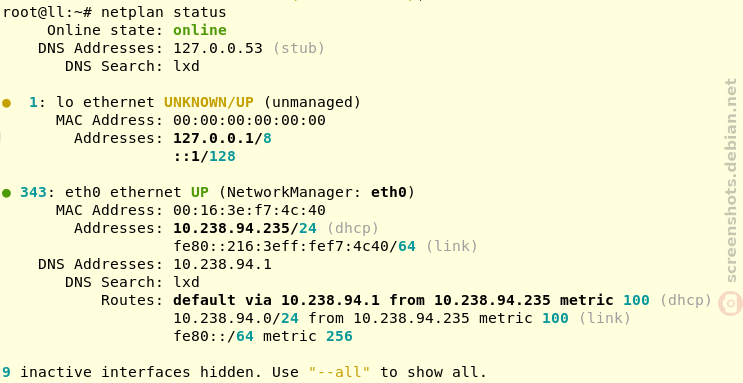

Sub SimpleMacro

MsgBox "Dies ist ein automatisierter Prozess!"

End SubFür komplexere Automatisierungen bieten sich Skripte in Python oder JavaScript an. Diese Skripte können komplexe Berechnungen durchführen oder Daten aus verschiedenen Quellen integrieren. Durch die Nutzung dieser Skripte auf dedizierten Servern kann die Verarbeitungsgeschwindigkeit erheblich gesteigert werden.

Integration mit Datenbanken

Eine weitere Möglichkeit zur Effizienzsteigerung ist die Integration von LibreOffice mit externen Datenbanken. Dies ermöglicht den automatisierten Import und Export von Daten, wodurch manuelle Eingaben minimiert werden. Beispielsweise kann ein Skript automatisch Daten aus einer SQL-Datenbank abrufen, analysieren und in einem LibreOffice Calc-Dokument darstellen.

Implementierung auf dedizierten Servern

Die Implementierung von Automatisierungstechniken auf dedizierten Servern erfordert eine gezielte Planung und Ausführung. Hierbei spielen Skalierung und Sicherheit eine entscheidende Rolle.

Skalierung und Leistung

Um die Leistung zu maximieren, sollten Automatisierungsprozesse so konzipiert werden, dass sie die Ressourcen des Servers optimal nutzen. Dazu gehört die parallele Verarbeitung von Aufgaben und die effiziente Nutzung von Speicher und CPU. Ein Beispiel für eine skalierbare Lösung ist die Nutzung von Docker-Containern, um LibreOffice-Instanzen in isolierten Umgebungen auszuführen. Dies ermöglicht es, mehrere Prozesse gleichzeitig zu betreiben, ohne dass es zu Ressourcenengpässen kommt.

Sicherheit und Wartung

Sicherheit ist ein wesentlicher Aspekt bei der Automatisierung auf dedizierten Servern. Es ist wichtig, dass alle Automatisierungsprozesse regelmäßig auf Sicherheitslücken überprüft werden. Zudem sollten Backups und Wiederherstellungspläne vorhanden sein, um Datenverlust zu vermeiden.

Vorteile der Automatisierung

Die Implementierung erweiterter Automatisierungstechniken in LibreOffice bietet zahlreiche Vorteile, die weit über die reine Effizienzsteigerung hinausgehen.

- Zeitersparnis: Automatisierung reduziert die Notwendigkeit manueller Eingaben und ermöglicht es, komplexe Aufgaben in kürzerer Zeit zu erledigen.

- Fehlerreduktion: Durch die Automatisierung werden menschliche Fehler minimiert, was die Genauigkeit der Datenverarbeitung erhöht.

- Kosteneffizienz: Die Reduzierung der benötigten Arbeitszeit führt zu einer Senkung der Betriebskosten.

- Skalierbarkeit: Automatisierte Prozesse lassen sich leicht an wachsende Datenmengen anpassen, ohne dass die Leistung darunter leidet.

Vergleichstabelle: Vorher und Nachher der Automatisierung

| Kriterium | Vor Automatisierung | Nach Automatisierung |

|---|---|---|

| Bearbeitungszeit | Hoch | Niedrig |

| Fehlerquote | Hoch | Niedrig |

| Betriebskosten | Hoch | Gering |

Durch die gezielte Implementierung von Automatisierungstechniken in LibreOffice können Unternehmen ihre Effizienz erheblich steigern und gleichzeitig die Qualität ihrer Datenverarbeitung verbessern. Dedizierte Server bieten die ideale Plattform, um diese Techniken effektiv einzusetzen und das volle Potenzial von LibreOffice auszuschöpfen.

Erweiterte Automatisierungsmöglichkeiten in LibreOffice

LibreOffice bietet nicht nur grundlegende Makros und Skripte, sondern auch eine Vielzahl erweiterter Automatisierungsmöglichkeiten, die es ermöglichen, noch komplexere Aufgaben effizient zu bewältigen. Diese Techniken erfordern ein tieferes Verständnis der LibreOffice-APIs und können maßgeschneiderte Lösungen für spezifische Geschäftsanforderungen schaffen.

UNO-API für erweiterte Anpassungen

Die Universal Network Objects (UNO)-API von LibreOffice ist eine leistungsstarke Möglichkeit, um tief in die Automatisierung von Prozessen einzutauchen. Sie erlaubt es Entwicklern, benutzerdefinierte Funktionen zu erstellen, die weit über die Möglichkeiten einfacher Makros hinausgehen. Mit der UNO-API können beispielsweise individuelle Benutzeroberflächen angepasst oder spezielle Datenverarbeitungsroutinen implementiert werden. Dadurch lässt sich die Software perfekt an die spezifischen Bedürfnisse eines Unternehmens anpassen.

Verwendung von Batch-Prozessen

Batch-Prozesse sind ein weiterer Ansatz zur Automatisierung, der besonders auf dedizierten Servern effektiv eingesetzt werden kann. Sie ermöglichen die Verarbeitung großer Datenmengen in einem einzigen Durchlauf, ohne dass ein menschliches Eingreifen erforderlich ist. Ein typisches Szenario wäre das nächtliche Generieren von Berichten oder die Aktualisierung von Datenbanken, während die Serverauslastung gering ist. Diese Prozesse können so geplant werden, dass sie außerhalb der regulären Arbeitszeiten stattfinden, um die Ressourcen optimal zu nutzen.

Automatisierte Dokumentenverarbeitung

Ein häufiges Einsatzgebiet für die Automatisierung in LibreOffice ist die automatisierte Verarbeitung von Dokumenten. Dazu gehört das Generieren von Serienbriefen, das Zusammenführen von Dokumenten oder das Konvertieren von Dateien in verschiedene Formate. Diese Aufgaben können durch Automatisierung nicht nur schneller, sondern auch konsistenter erledigt werden. Beispielsweise kann ein Skript erstellt werden, das automatisch alle relevanten Informationen aus einer Datenbank zieht und sie in ein vordefiniertes Dokument einfügt.

Best Practices für die Automatisierung

Die Implementierung fortschrittlicher Automatisierungstechniken erfordert sorgfältige Planung und Durchführung. Es gibt einige Best Practices, die Unternehmen berücksichtigen sollten, um den Erfolg ihrer Automatisierungsprojekte sicherzustellen.

Iterative Entwicklung und Testing

Automatisierungslösungen sollten schrittweise entwickelt werden, um Fehler frühzeitig zu erkennen und zu beheben. Es ist ratsam, zunächst mit einem kleinen, überschaubaren Projekt zu beginnen und die Lösung schrittweise zu erweitern. Regelmäßiges Testing ist unerlässlich, um sicherzustellen, dass alle automatisierten Prozesse wie erwartet funktionieren und keine unerwarteten Probleme verursachen.

Schulung und Weiterbildung

Die Einführung neuer Automatisierungstechniken erfordert oft eine Umstellung der Arbeitsweise. Mitarbeiter sollten entsprechend geschult werden, um die neuen Systeme effektiv nutzen zu können. Dies umfasst sowohl die Bedienung der automatisierten Prozesse als auch ein grundlegendes Verständnis der zugrunde liegenden Technologien, um bei Bedarf Anpassungen vornehmen zu können.

Dokumentation und Wissensmanagement

Eine umfassende Dokumentation ist entscheidend für den langfristigen Erfolg von Automatisierungsprojekten. Alle entwickelten Skripte, Makros und Prozesse sollten detailliert dokumentiert werden, um sicherzustellen, dass sie auch von anderen Teammitgliedern verstanden und gewartet werden können. Ein effektives Wissensmanagement hilft, das gesammelte Wissen zu bewahren und neuen Mitarbeitern zugänglich zu machen.

Beispiele aus der Praxis

Viele Unternehmen haben bereits erfolgreich Automatisierungstechniken in LibreOffice implementiert und konnten dadurch signifikante Verbesserungen in ihrer Effizienz und Datenverarbeitung erzielen.

Fallstudie: Finanzberichtserstellung

Ein mittelständisches Unternehmen im Finanzsektor nutzte die Automatisierung in LibreOffice, um den Prozess der Finanzberichtserstellung zu optimieren. Vor der Automatisierung wurden die Berichte manuell erstellt, was zu Inkonsistenzen und Verzögerungen führte. Durch die Implementierung automatisierter Skripte, die Daten aus verschiedenen Quellen zusammenführten und in standardisierte Berichtsvorlagen einfügten, konnte die Bearbeitungszeit um über 50% reduziert und die Genauigkeit der Berichte erheblich gesteigert werden.

Fallstudie: Verwaltung von Kundendaten

Ein weiteres Beispiel ist ein Einzelhandelsunternehmen, das die Automatisierung nutzte, um seine Kundendaten effizienter zu verwalten. Durch die Integration von LibreOffice mit der bestehenden CRM-Datenbank konnte das Unternehmen den Prozess der Datenaktualisierung automatisieren, was zu einer verbesserten Datenqualität und einer personalisierteren Kundenansprache führte.

Durch den Einsatz von Automatisierungstechniken in LibreOffice auf dedizierten Servern können Unternehmen nicht nur ihre Effizienz steigern, sondern auch die Qualität ihrer Geschäftsprozesse verbessern. Die vielfältigen Möglichkeiten, die LibreOffice bietet, ermöglichen es, maßgeschneiderte Lösungen für unterschiedlichste Anforderungen zu entwickeln. Die sorgfältige Planung, Implementierung und Wartung dieser Systeme ist der Schlüssel zum Erfolg in der modernen, datengetriebenen Geschäftswelt.